一言でいうと

ニューラルネットワークのパラメータ間の距離と最適化の安定性の関係について分析.

論文リンク

https://arxiv.org/pdf/2002.03432.pdf

著者/所属機関

J Bernstein (Caltech), A Vahdat (NVIDIA), Y Yue Caltech, MY Liu (NVIDIA)

投稿日付(yyyy/MM/dd)

2020/06/12

概要

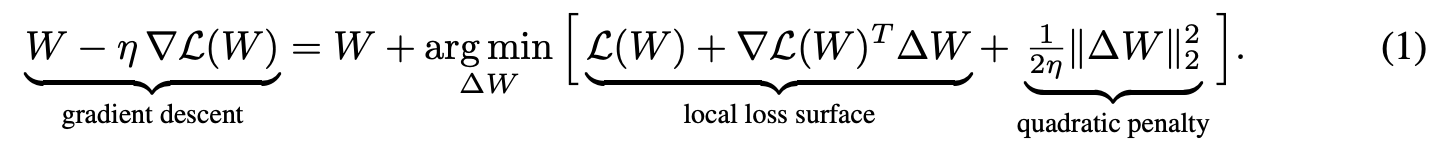

ニューラルネットワークの勾配降下法における二次罰則の項を,ニューラルネットの構造に合わせた新しい距離関数で置き換える:

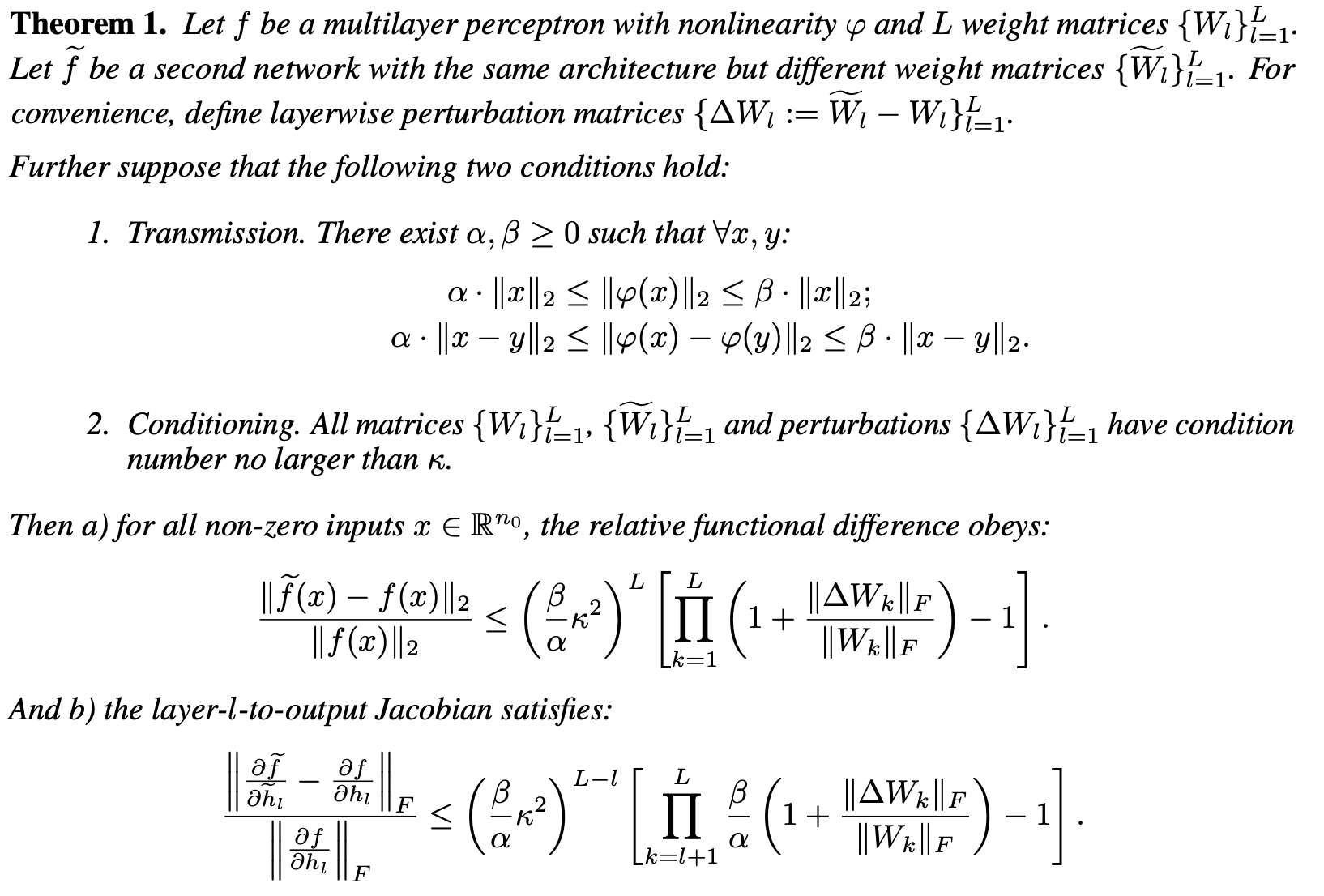

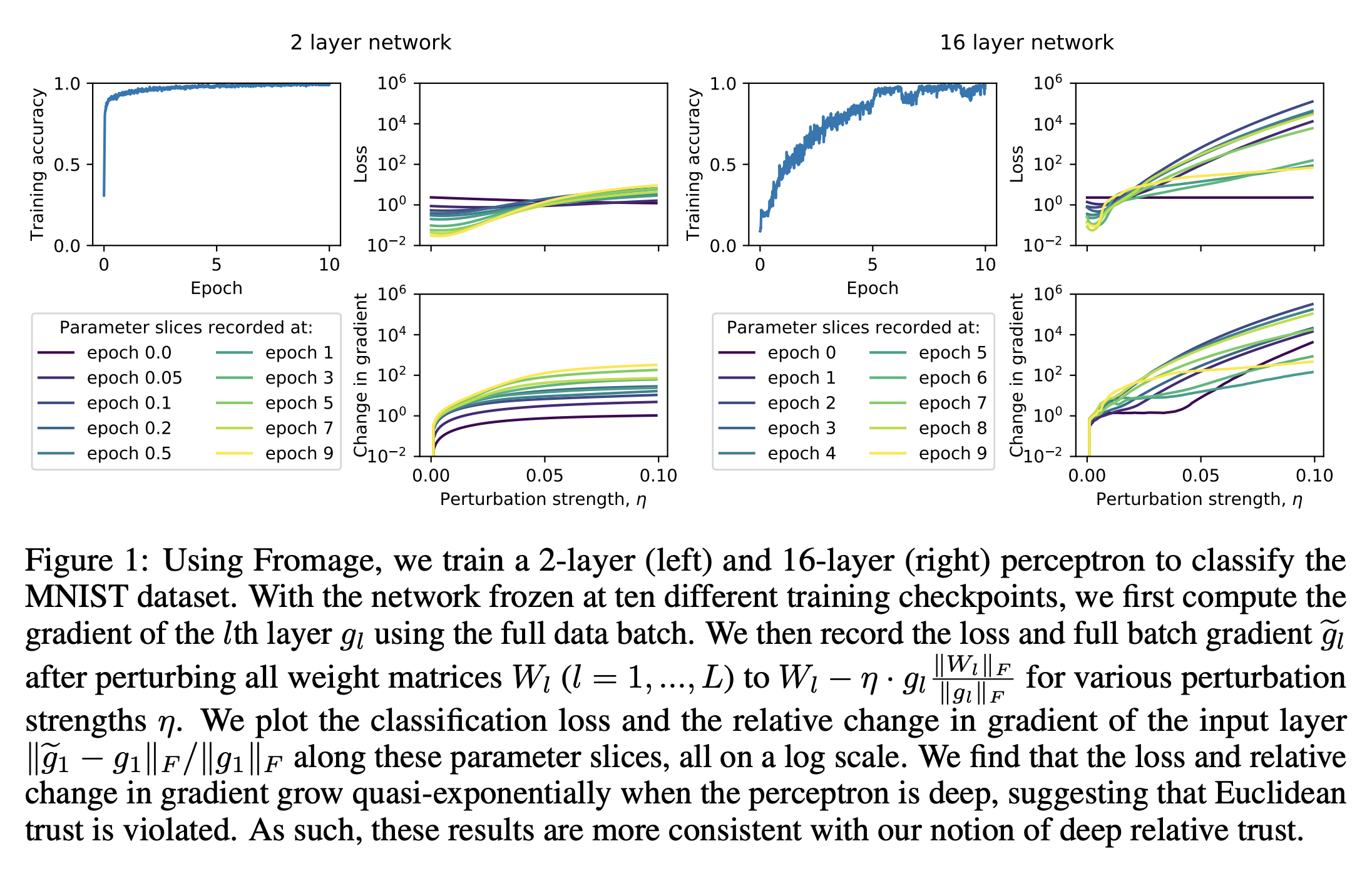

- ニューラルネットワークとヤコビアンの摂動解析から,新しい距離関数であるdeep relative trustを導出.

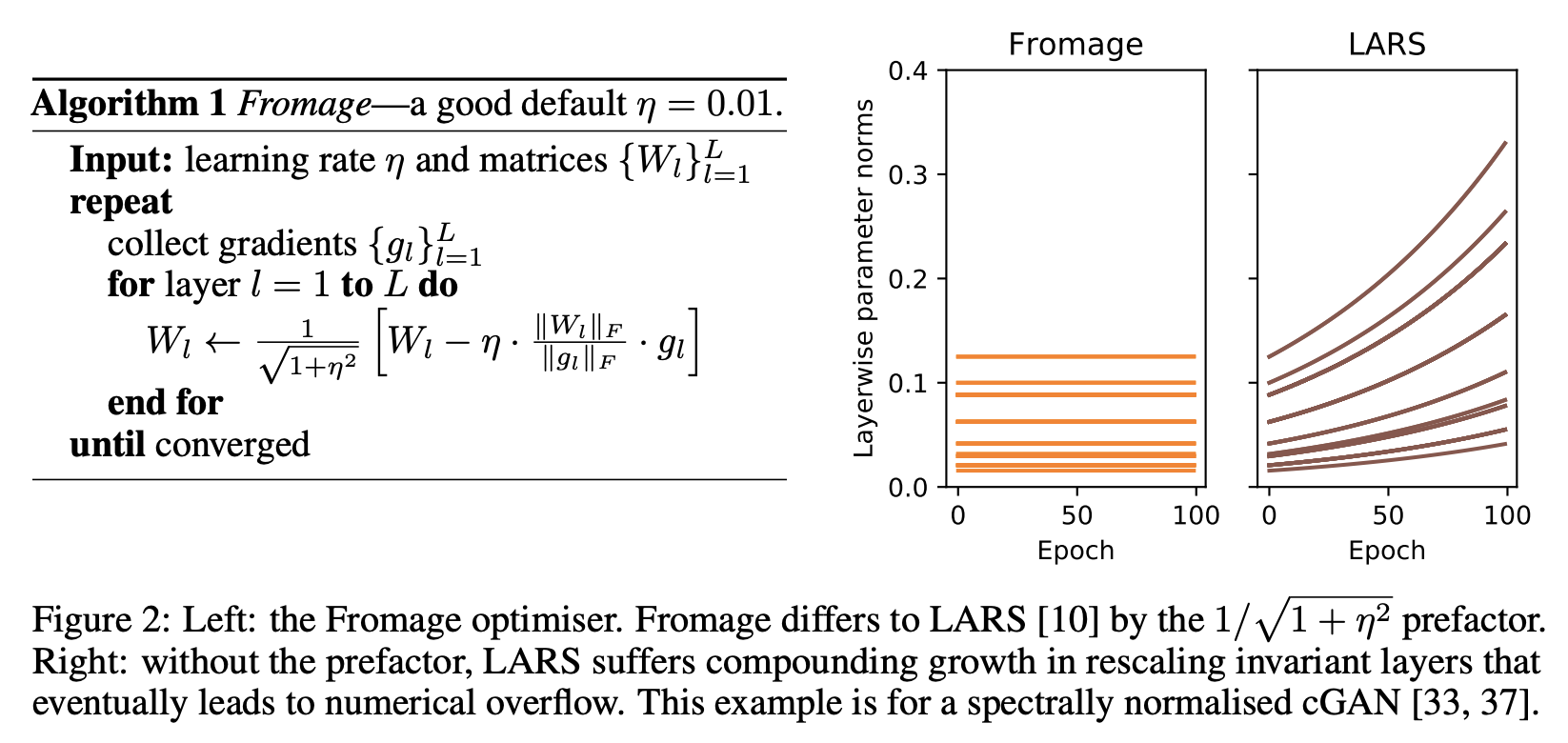

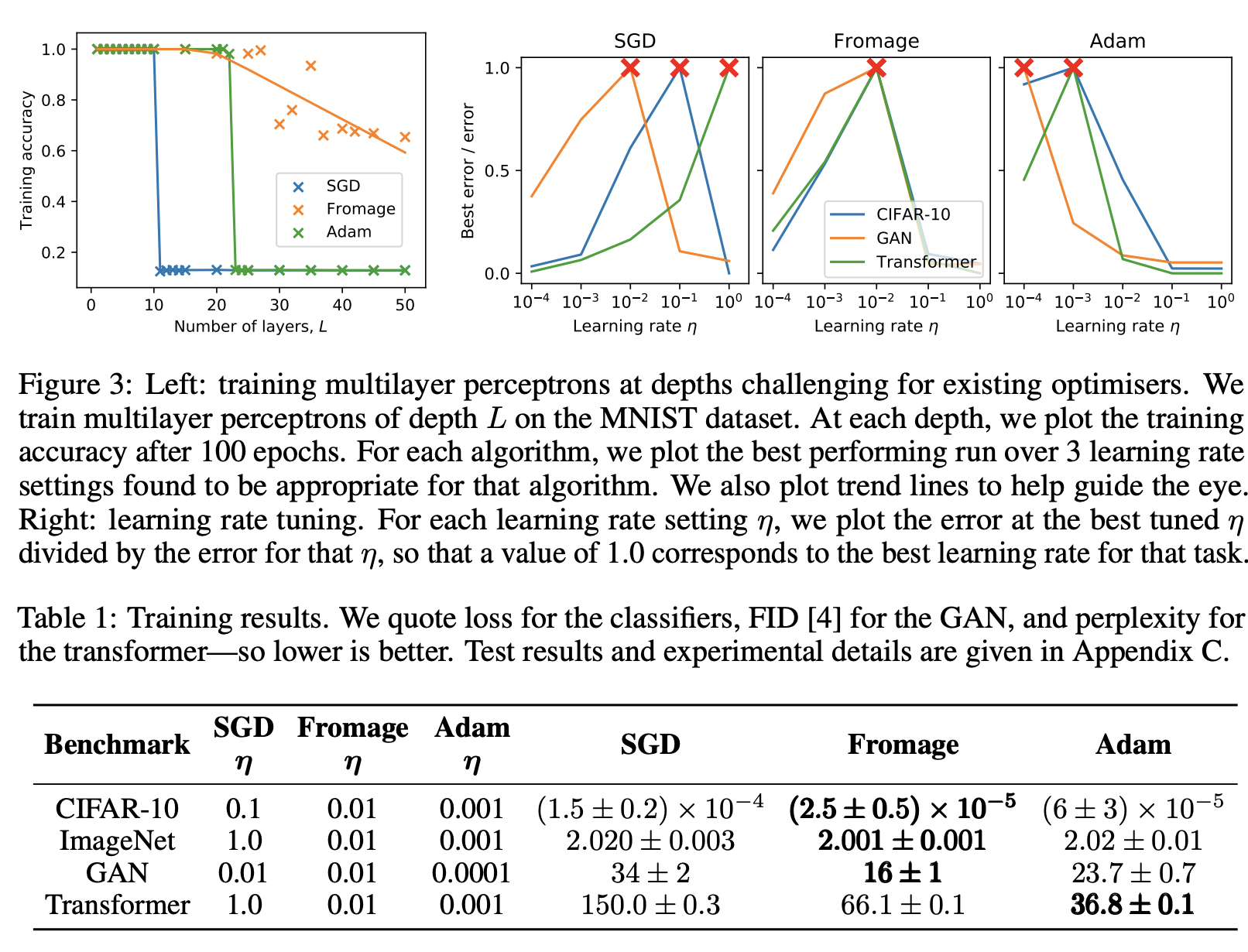

- この距離関数から導出される補題から,新しい学習アルゴリズムであるFrobenius matched gradient descent (Fromage)を導出.

- 多数のタスクにおいて, Fromageは学習率チューニングなしに良好な性能を達成可能.

新規性・差分

勾配法とパラメータの関係についての分析から,ニューラルネットワークのより深い理解につながる.

手法

結果

コメント