-

Notifications

You must be signed in to change notification settings - Fork 0

Open

Labels

Description

公開日

2017-08-22

1. 概要

Deep learningは各分野で成果を出しているが、計算リソースが必要になるため、クラウド上で学習するサービス(MLaaS)がある。また、既存のモデルを利用したり、転移学習させることでコストを下げる方法があり、アウトソーシングが主流になりつつある。だが、学習時にバックドアをネットワークに仕込むことができ、通常のテストケースでは何も問題がないものの、特定のトリガーを入力させることで誤識別させることができる。これをBadNetsと呼ぶ。

2. 新規性・差分

3. 手法

outsourced training attack

モデルの形とデータセットをクラウドに投げて、学習結果のパラメータを受け取る場合を考える。

BadNetsモデルの条件:

- val accを低下させてはいけない(val dataは未知)

- トリガーを入力したとき、正常に訓練したモデルとは異なる予測を出力する(標的型・非標的型の2パターンある)

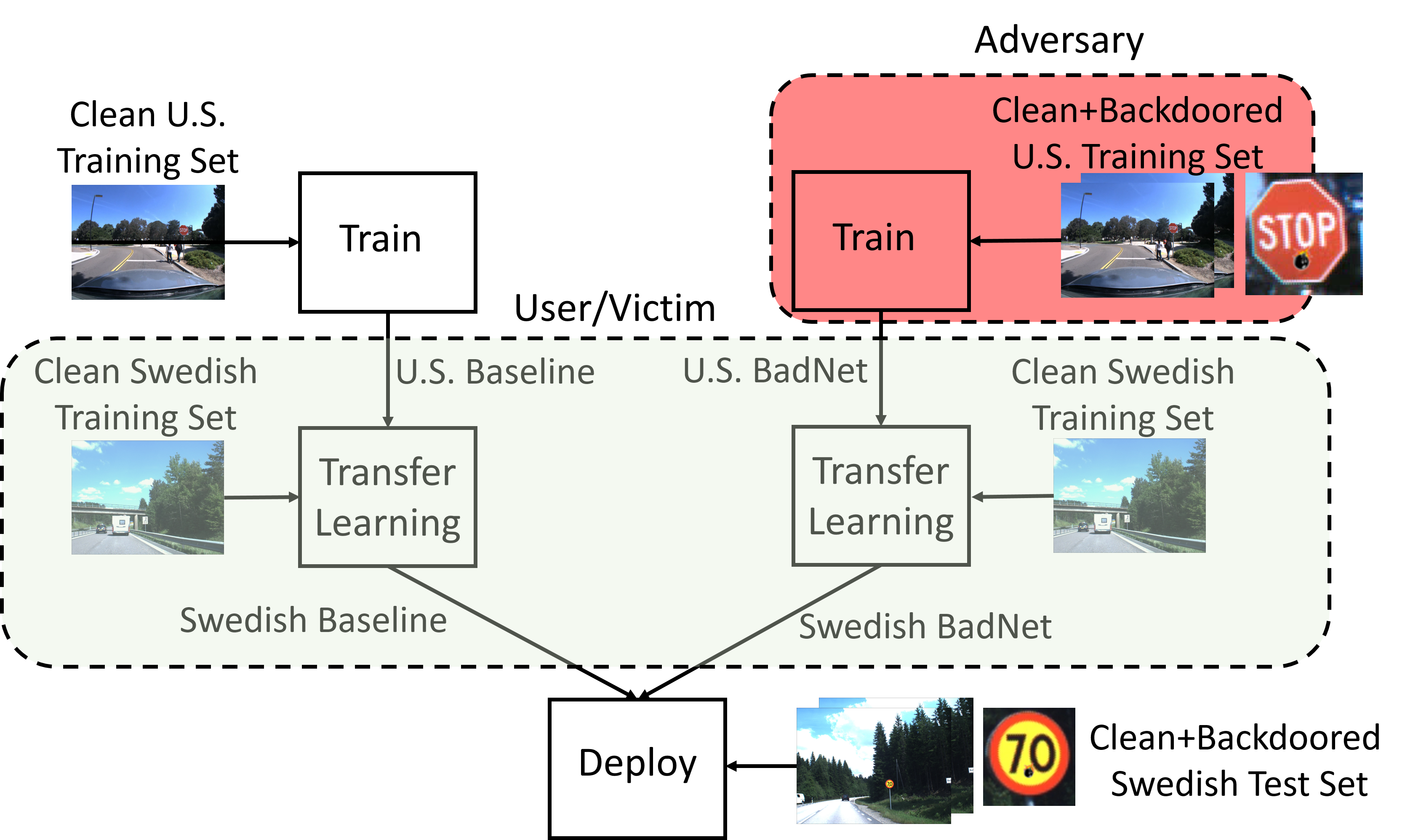

transfer learning attack

ユーザが悪意を持って学習されたモデルをダウンロードして、転移学習する場合を考える。

BadNetsモデルの条件:

- 新しいアプリケーションに対して設定されたユーザのval accが高くなければならない

- トリガーを入力したとき、正常に訓練したモデルとは異なる予測を出力する

どちらにせよ、学習データにトリガーとなるデータを仕込むことによってバックドアを作成する。

4. 結果

MNIST

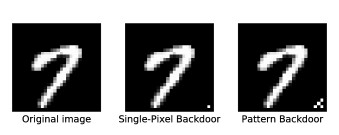

以下のようなデータを混ぜた

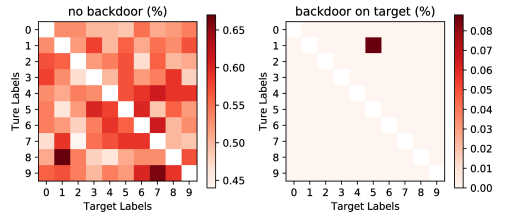

結果、すごいいい感じに間違えていて、標的型のバックドアを仕込めていると言える。

悪意のあるデータは、全体の10%くらいでうまくいく。

Transfer learning

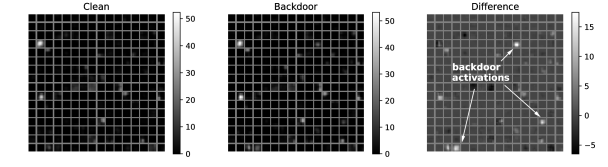

いい感じに間違えさせられていて、以下のようにconv5のactivationを可視化させたら、backdoorの発火するポイントがわかる。

(他にも結果はいっぱいあるので気になる方は論文見てください)

5. 議論

DNNのバックドアを検出する技術を研究する必要がある。

6. コメント

防御手法もちゃんと提案してくれ…